Dla większości osób sprawą dość oczywistą wydaje się, że urządzenia przemysłowe pracują przy różnym poziomie ryzyka uszkodzeń, zależnie od tego, jakie zadanie realizują i w jakim środowisku są zaimplementowane.

Wypracowano wiele metod niezbędnych do odpowiedniego zaprojektowania systemów zabezpieczenia, ograniczających wspomniane ryzyko. Jednak pytania związane z doborem technologii wciąż padają z ust użytkowników, właścicieli fabryk i inżynierów: czy stosować układy przekaźnikowe, pneumatyczne, programowalne; jaki poziom redundancji – pojedynczy, podwójny czy potrójny; jak często sprawdzać i testować systemy – co miesiąc, kwartał, rok, a może tylko przy zaplanowanym wyłączeniu linii produkcyjnych? Debata trwa, skupiając się na kwestiach wyboru modelu decyzyjnego, pozwalającego jednoznacznie odpowiedzieć na powyższe i podobne pytania. Czy bazować na doświadczeniach i danych z przeszłości, czy może ocenach jakościowych lub wynikach analiz ilościowych?

Współczesne standardy krajowe i międzynarodowe, dotyczące zasad projektowania przemysłowych systemów bezpieczeństwa, zorientowane są bardziej na uzyskiwanie jak najlepszych bieżących wskaźników wydajności i optymalności procesów, niż na długofalowe perspektywy użytkowania maszyn i modułów systemowych. Nie narzuca się w nich konkretnych rozwiązań technologicznych, koniecznych poziomów redundancji czy okresów międzytestowych. Wskazuje się natomiast, co musi być zrobione dla uzyskania odpowiedniego poziomu bezpieczeństwa maszyn i urządzeń, bez zaleceń konkretnych metod realizacji.

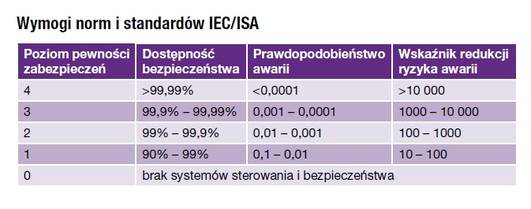

Dla przykładu dokumenty międzynarodowe określają cztery poziomy pewności zabezpieczeń SIL dla procesów przemysłowych, podając odpowiednie wymogi co do niezawodności ich funkcjonowania dla każdego z takich poziomów.

Historia przemysłowych systemów bezpieczeństwa

Jeszcze trzydzieści lat temu projektowanie przemysłowych systemów bezpieczeństwa było sprawą dość prostą, bazującą tak naprawdę na kombinacji elementów wyłączających, różnego typu blokad, barier itp. Instalowane wówczas systemy sterowania zawierały sterowniki z pojedynczymi pętlami sprzężeń zwrotnych, a systemy bezpieczeństwa były instalacjami odrębnymi, bez żadnych powiązań i interakcji z innymi systemami w zakładzie czy budynku, zwykle współpracującymi jedynie z prostymi układami przekaźnikowymi, o dobrze znanych charakterystykach awaryjności i możliwych przyczynach awarii (rys. 1). Przy uwzględnieniu tych wszystkich czynników, dobrze zaprojektowany tego typu system można było nazwać relatywnie bezpiecznym. Jednakże wraz ze wzrostem liczby obsługiwanych wejść i wyjść powyżej dwudziestu coraz szybciej i częściej ujawniały się wady tego typu rozwiązań. Rosnąca liczba przewodów i kabli stała się niezwykle kłopotliwa i nieporęczna, wzajemne powiązania logiczne coraz trudniejsze do opanowania i wprowadzania ewentualnych zmian, nie było możliwości zdalnego prowadzenia diagnostyki, brak cyfrowej komunikacji, a dokumentacja z reguły sporządzana była ręcznie.

Jeszcze trzydzieści lat temu projektowanie przemysłowych systemów bezpieczeństwa było sprawą dość prostą, bazującą tak naprawdę na kombinacji elementów wyłączających, różnego typu blokad, barier itp. Instalowane wówczas systemy sterowania zawierały sterowniki z pojedynczymi pętlami sprzężeń zwrotnych, a systemy bezpieczeństwa były instalacjami odrębnymi, bez żadnych powiązań i interakcji z innymi systemami w zakładzie czy budynku, zwykle współpracującymi jedynie z prostymi układami przekaźnikowymi, o dobrze znanych charakterystykach awaryjności i możliwych przyczynach awarii (rys. 1). Przy uwzględnieniu tych wszystkich czynników, dobrze zaprojektowany tego typu system można było nazwać relatywnie bezpiecznym. Jednakże wraz ze wzrostem liczby obsługiwanych wejść i wyjść powyżej dwudziestu coraz szybciej i częściej ujawniały się wady tego typu rozwiązań. Rosnąca liczba przewodów i kabli stała się niezwykle kłopotliwa i nieporęczna, wzajemne powiązania logiczne coraz trudniejsze do opanowania i wprowadzania ewentualnych zmian, nie było możliwości zdalnego prowadzenia diagnostyki, brak cyfrowej komunikacji, a dokumentacja z reguły sporządzana była ręcznie.

Systemy przekaźnikowe charakteryzowały się stosunkowo niską ceną zakupu, jednak w dłuższej perspektywie ogólne koszty utrzymania takich instalacji były dość znaczne. Ponadto ze swej natury są to systemy jednokierunkowe i proste pod względem możliwych do realizacji zależności logicznych, stąd też wynikały podstawowe bolączki ich użytkowników, związane z przypadkowymi wyłączeniami, nieuzasadnionymi przestojami produkcji i w rezultacie stratami finansowymi.

Wprowadzenie sterowników PLC (1969 r.)

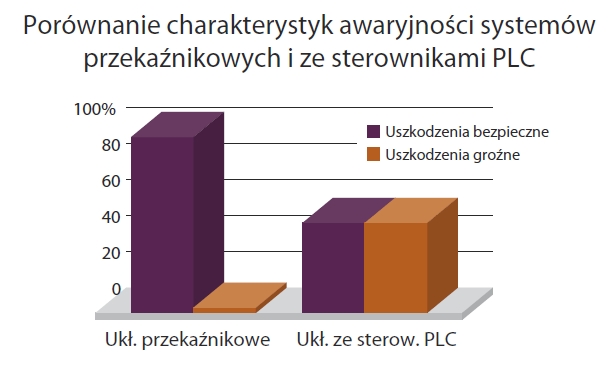

Był to przełomowy moment w historii rozwoju systemów sterowania, który przyczynił się do zasadniczych zmian w ich architekturze, sposobie organizacji i realizacji zadań. Ówczesne sterowniki PLC projektowane były głównie z myślą o zastąpieniu funkcjonujących rozwiązań przewodowo-przekaźnikowych i oferowały wiele korzyści związanych głównie ze wzrostem elastyczności, zmniejszeniem rozmiarów, niższymi kosztami eksploatacji oraz opracowywaniem dokumentacji funkcjonalnej i sprzętowej. W większości jednak nie nadawały się one do bezpośredniego zastosowania w systemach bezpieczeństwa, ze względu na swoje charakterystyki awaryjności. Wskazywały na znacznie większą ilość możliwych poważniejszych uszkodzeń sterownika, w porównaniu do odpowiednich układów przekaźnikowych (rys. 2). Niestety wielu użytkowników nie miało (a niektórzy nie mają do tej pory) świadomości tego faktu. Innym ograniczeniem związanym z możliwością stosowania sterowników PLC w systemach bezpieczeństwa jest brak skutecznych metod diagnostyki, szczególnie w odniesieniu bezpośrednio do modułów wejść/wyjść.

Technologie alternatywne

Technologie alternatywne

Ze względu na wady i ograniczenia obu wspomnianych wcześniej technologii na rynku systemów bezpieczeństwa pojawiły się inne, alternatywne rozwiązania, korzystające z układów półprzewodnikowych i scalonych. Takie systemy były już projektowane wyłącznie do zastosowań w sferze bezpieczeństwa i pozwalały na realizację wielu charakterystycznych funkcji, jak: kompletna diagnostyka i testy układów, komunikacja cyfrowa między modułami systemowymi, realizacja bardziej zaawansowanych algorytmów funkcjonowania i zależności logicznych. W systemach tego typu nie korzystano z dodatkowego oprogramowania, stąd nie występował problem możliwych błędów programowych czy zagrożenia wirusami. W niektórych jednak aplikacjach wspomniany brak oprogramowania był raczej cechą negatywną – np. w obsłudze procesów produkcji seryjnych. Jednakże podstawową wadą omawianych systemów był koszt ich zakupu i implementacji, wynoszący zwykle ponad 1500 USD na pojedyncze we/wy, do w pełni funkcjonalnego i zintegrowanego systemu.

Pierwsza generacja sterowników PLC do systemów bezpieczeństwa

Przemysł lotniczy i kosmonautyczny w USA sponsorował badania zmierzające do opracowania komputerów o podwyższonej odporności na uszkodzenia i pewnej tolerancji na błędy, które doprowadziły w efekcie do rozwoju systemów z trójmodułową redundancją (TMR). Pozwalają one na niezawodną pracę systemu nawet w momencie wystąpienia błędów – kanał informacji, który nie spełnia określonych parametrów, jest automatycznie odłączany – stąd hasło „tolerowania błędów”. Systemy tego typu są jednak dla wielu niewielkich procesów, charakteryzujących się małym ryzykiem wystąpienia błędów i awarii, rozwiązaniami zbyt zaawansowanymi funkcjonalnie i sprzętowo, szczególnie wziąwszy pod uwagę, że znakomita większość systemów TMR jest łączona z urządzeniami w trybie simplex.

Systemy bezpieczeństwa z zaawansowaną diagnostyką

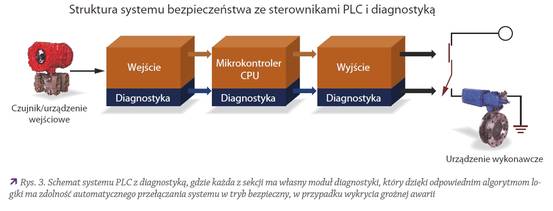

Na początku lat 90. ubiegłego stulecia rozpoczęła się nowa era rozwoju sterowników PLC do systemów bezpieczeństwa, w których zastosowano najnowsze zdobycze technologii procesorowych, umożliwiające tworzenie i wykorzystanie nowych funkcji diagnostycznych zintegrowanych z pewną hierarchią struktury systemowej, co pozwoliło na zwiększenie bezpieczeństwa i dostępu do funkcjonalności systemowych. U podstaw ich koncepcji legło założenie, że wykorzystanie dostępnej inteligencji systemu pozwoli na ograniczenie liczby niezbędnych modułów, dzięki czemu cały system będzie tańszy, zachowując ten sam poziom bezpieczeństwa i dostępności, jak w przypadku wspomnianych systemów TMR. W systemach z zaawansowaną diagnostyką stosuje się zwykle architektury połączeń typu 1oo1D, 1oo2D itp., gdzie symbol „D” związany jest z możliwościami diagnostycznymi, które w przeciwieństwie do wielu innych rozwiązań oferowanych na rynku mają możliwość automatycznego wysterowania systemu do pracy w tzw. stanie bezpiecznym w momencie pojawienia się zagrożenia lub awarii (rys. 3).

Aspekty prawne

W Polsce i Unii Europejskiej podstawowymi dokumentami w zakresie bezpieczeństwa funkcjonalnego systemów do zastosowań w przemyśle procesowym są normy: PN-EN 61508 (w zakresie opracowywania urządzeń; poziomy bezpieczeństwa SIL) oraz PN-EN 61511 (w zakresie wymagań wobec przyrządowych systemów bezpieczeństwa do sektora procesów przemysłowych; opracowanie modeli i architektur systemowych). Pojawia się w nich wiele terminów, definicji i wskaźników, używanych powszechnie przy opisie i projektowaniu współczesnych systemów bezpieczeństwa. Niektóre z nich wymagają szerszego komentarza, ze względu na ich znaczenie i możliwość niewłaściwej interpretacji.

Pojęcie dostępności i jego znaczenie

Wielu inżynierów automatyków i utrzymania ruchu zna doskonale termin dostępności, określany jako stosunek czasu sprawności (działania) maszyny do całkowitego okresu jej użytkowania. Jednakże pojęcie to często bywa nieprawidłowo interpretowane. Cóż bowiem faktycznie oznacza to, że np. dostępność wynosi 99,9%? Oczywiście sam wskaźnik wygląda świetnie – ale co to znaczy?

System sterowania, który realizuje procedury bezpiecznego wyłączenia raz w miesiącu na okres 40 minut, ma właśnie wskaźnik dostępności na poziomie 99,9%. Ale ten sam wskaźnik dotyczy również systemu realizującego takie wyłączenie raz w roku na 9 godzin, podobnie system wyłączający raz na dziesięć lat na 90 godzin itd. Aby kalkulacja wskaźnika dostępności była miarodajna, tak naprawdę istotne jest podsumowanie rzeczywistego czasu wyłączenia i bezruchu maszyn w procesie produkcyjnym. Na ile sensowne i rzeczowe będą roszczenia producenta czy dostawcy urządzenia, jeżeli w swoich obliczeniach i danych technicznych uwzględni on tylko 1 godzinę niezbędną dla wykonania naprawy, bez wzięcia pod uwagę kolejnych 12 godzin koniecznych do ponownego uruchomienia maszyny i całego procesu produkcji? Tak obliczone wskaźniki będą mieć bardzo dobrze wyglądające wartości, nie będą jednak odzwierciedlać rzeczywistej dostępności maszyn.

W przepisach dotyczących bezpieczeństwa funkcjonalnego obowiązuje termin Średniego Czasu do Wystąpienia Usterki (MTTF). Dzięki niemu różnica pomiędzy systemami realizującymi wyłączenia raz na 6 miesięcy, raz na 6 lat, raz na 60 czy 600 lat jest właściwie oczywista. Użytkownik wie, jak długo proces będzie zatrzymany, jeżeli wystąpi awaria, ale chce również wiedzieć, jak często może się to przytrafić.

Skuteczność systemów bezpieczeństwa

Skuteczność systemów bezpieczeństwa

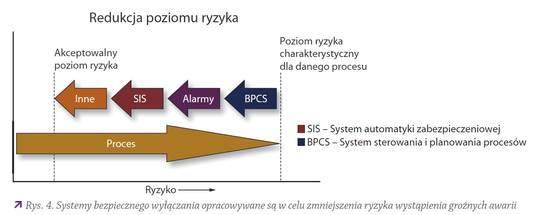

Różne osoby używają różnych terminów dla określenia skuteczności działania systemów bezpieczeństwa. Na rys. 4 pokazano jedną z koncepcji, jak systemy bezpieczeństwa realizujące wyłączenia mogą być użyte w celu redukcji ryzyka niebezpieczeństwa funkcjonowania procesów do pewnego akceptowalnego poziomu. Opisana tu skuteczność często przedstawiana jest pod hasłem redukcji poziomu ryzyka. Krótko mówiąc, „bezpieczniejszy” system bezpieczeństwa charakteryzuje się „lepszym” (większym) współczynnikiem redukcji ryzyka RRF, w stosunku do „gorszego” systemu bezpieczeństwa. Innymi słowy współczynnik RRF można zdefiniować jako „wartość, o jaką zmniejsza się całkowite ryzyko awarii urządzeń po instalacji systemów bezpieczeństwa, w stosunku do rozwiązania bez takich systemów”.

Podstawowe zasady projektowania i organizacji systemów bezpieczeństwa podane są w dwóch dokumentach standaryzujących: ISA S84 oraz IEC 1508 (Bezpieczeństwo funkcjonalne – Systemy bezpieczeństwa). W każdym z nich przedstawiono koncepcję opartą na wskaźnikach poziomu pewności zabezpieczeń SIL, rozumiane jako skuteczność systemu bezpieczeństwa w stosunku do poziomu ryzyka awarii, przypisanego dla danych urządzeń lub całych procesów.

Wskaźniki SIL umożliwiają oszacowanie ryzyka awarii „nie wprost”, zamiast tradycyjnych wskaźników, takich jak: szybkość zużycia i powstania awarii czy wskaźniki ryzyka uszkodzenia. Powód ich wprowadzenia i popularyzacji jest prosty: twórcy międzynarodowych standardów nie mogą sobie pozwolić na zaakceptowanie faktu, że świadomie, potencjalnie godzą się ze śmiercią statystycznie czterech osób na 100 mln roboczogodzin (jak to wynikało ze stosowanych dotychczas wskaźników).

W tabeli 1 można również dostrzec prostotę interpretacji liczb/wartości, w jakich wyrażany jest współczynnik RRF. Różnica pomiędzy wskaźnikami dostępności na poziomie 99% i 99,9% jest bardzo niewielka – mniej niż 1%. Jednocześnie dla tych samych wierszy różnica odpowiednich wskaźników RRF waha się między 10 a 10 000 i jest oczywista nawet dla małego dziecka. To różnica aż dwóch rzędów wielkości.

Inżynieria to dyscyplina bazująca na określeniach ilościowych. Decyzje dotyczące wymiarowania zaworów, rurociągów, wentylatorów i turbin są oparte na szczegółowych obliczeniach. Podobne procedury konieczne są przy doborze, projektowaniu i budowie współczesnych systemów bezpieczeństwa. Realizacja każdego z nich, ze względu na unikalność obsługiwanych aplikacji, zawsze jest sytuacją bez precedensu. Jednakże wraz z osiągnięciem zamierzonych wskaźników bezpieczeństwa w projektowanym systemie można się skupić na innych czynnikach umożliwiających redukcję kosztów instalacji, takich jak: wybrane języki programowania, kwestie połączeń i medium transmisyjnego, ochrony danych w systemie, rozmiary stosowanych modułów sterujących, czujników i elementów wykonawczych, możliwości i zakres zdalnego sterowania/monitoringu i wielu innych elementach, mających wpływ na niezawodność, skuteczność i wydajność systemu bezpieczeństwa.

Charles M. Fialkowski jest specjalistą systemów bezpieczeństwa w firmie Siemens Energy & Automation

Artykuł pod redakcją dr. inż. Andrzeja Ożadowicza – AGH Kraków

Autor: Charles M. Fialkowski